Integración de un sistema de neuroseñales para detectar expresiones en el análisis de material multimedia

Integration of a Neurosignals System to Detect Human Expressions in the Multimedia Material Analysis

Integração de um sistema de neuro-sinais para detectar expressões na análise de material multimídia

Luz Ángela Moreno-Cueva*, César Augusto Peña-Cortés**, Herney González-Sepúlveda***

* M.Sc. Universidad de Pamplona (Pamplona-Norte de Satander, Colombia). luzamoreno02@gmail.com

** Ph.D. Universidad de Pamplona (Pamplona-Norte de Satander, Colombia). cesarapc@unipamplona.edu.co

*** Esp. Universidad de Pamplona (Pamplona-Norte de Satander, Colombia). herney.gonzalezs@unipamplona.edu.co

Fecha de Recepción: 2 de Septiembre de 2014 Fecha de Aceptación: 9 de Octubre de 2014

Resumen

Presenta los avances realizados en la integración de un dispositivo comercial de bajo costo para capturar neuroseñales, con el fin de registrar expresiones de un usuario de material multimedia. Todas las personas adoptan diversos tipos de expresiones al ver televisión, películas, comerciales u otros textos. Ejemplos de estas expresiones son: apretar los dientes en escenas de suspenso; mover la cabeza hacia atrás cuando se da la sensación de arrojar un objeto hacia fuera de la pantalla en películas 3D; desviar la mirada en las escenas de terror; sonreír en comerciales emotivos; dar carcajadas en escenas de humor, e incluso quedarse dormido por el desinterés. La idea general de este sistema es capturar todas estas expresiones en conjunto, con señales emotivas tales como el nivel de atención, frustración y meditación, para que los expertos en creación del material multimedia puedan realizar un análisis y mejorar sus productos. Se presentan pruebas experimentales que evidencian el buen funcionamiento del sistema.

Palabras clave: Neurociencia, Multimedia, Procesamiento de señales, Expresiones.

Abstract

This paper presents the advances in the integration of a commercial low-cost device for capturing neural signals of a user. The idea is to record some expressions of a multimedia material user. Everyone performs various types of expressions watching TV, movies, ads or others external signals. Within these expressions can be highlighted some examples as: the clenching one's teeth with suspense scenes, moving one's head back when feeling an object is thrown out of the screen in one's direction dunging 3D movies; looking away during horror scenes; smiling in emotional trading, to laughter during humorous scenes or even fall asleep when there is disinterest. The general idea of this system is to capture all these expressions, together with emotive signals such as the level of attention, frustration and meditation, in order that the experts designers of multimedia material, can analyze and improve their products Experimental evidence is presented showing the good performance of the system.

Keywords: Neuroscience, Multimedia, Signal processing, Expressions.

Resumo

Apresenta os avanços realizados na integração de um dispositivo comercial de baixo custo para capturar neurosinais, com o objetivo de registrar expressões de um usuário de material multimídia. Todas as pessoas adotam diversos tipos de expressões ao ver televisão, filmes, comerciais ou outros textos. Exemplos destas expressões são: apertar os dentes em cenas de suspenso; mover a cabeça para trás quando se dá a sensação de atirar um objeto para fora da tela em filmes 3D; desviar o olhar nas cenas de terror; sorrir em comerciais emotivos; dar gargalhadas em cenas de humor, e incluso ficar dormido pelo desinteresse. A ideia geral deste sistema é capturar todas estas expressões em conjunto, com sinais emotivos tais como o nível de atenção, frustração e meditação, para que os expertos em criação do material multimídia possam realizar uma análise e melhorar seus produtos. Apresentam-se provas experimentais que evidenciam o bom funcionamento do sistema.

Palavras chave: Neurociência, Multimídia, Processamento de sinais, Expressões.

I. Introducción

El desarrollo de componentes audiovisuales supone hoy un reto mayor a sus diseñadores, pues cada día es más difícil sorprender a los diversos usuarios de computadores, teléfonos inteligentes, tablas, televisores inteligentes, etc.; esto se debe a que los grandes avances en las técnicas de animación crean en los usuarios la idea de que todo es posible de recrear, lo cual eleva la expectativa de los usuarios y los hace más críticos y restrictivos frente a los errores o la falta de detalles.

Para un diseñador es difícil saber antes de que el material producido sea visto por un número significativo de usuarios si este tiene un alto impacto o cumple con las expectativas de estos; por esta razón, los diseñadores se la juegan al todo o nada al plantear sus ideas durante el desarrollo de sus contenidos. En este orden de ideas, los diseñadores deben conocer muy bien a su público e intentar generar ideas de acuerdo con el gusto de los usuarios.

Una de las principales aplicaciones del material multimedia es la publicidad, que busca persuadir al consumidor para que compre un servicio o producto, y se emite en varios medios, como Internet, televisión, radio y prensa, entre otros. Es por esto que esta área es fundamental para el Departamento de Marketing de una empresa [1], cuyo propósito es alcanzar los objetivos de esta, que, en la gran mayoría de casos, consisten en generar rentabilidad a sus propietarios.

El análisis de comerciales ha sido decisivo para los publicistas; mediante éstos, las organizaciones pueden llegar a la captura eficiente de clientes y a su fidelización; es por ello que cualquier pauta publicitaria debe estar constituida por múltiples factores atractivos que puedan introducirse y posicionarse en la mente del consumidor [2]. Se debe tener en cuenta que las personas, por lo general, tienden a ser muy influidas por los comerciales y por los comentarios que genera la población que se encuentra a su alrededor (a este fenómeno se le conoce como publicidad voz a voz), lo cual es un factor decisivo al momento de la compra; es decir, toman importancia los recuerdos de los mensajes que han podido precisar en alguna ocasión de su vida. Por lo anterior, es de gran importancia realizar una serie de herramientas que permitan medir y evaluar las diversas pautas publicitarias antes de mostrarlas al público en general.

Con el fin de garantizar que los contenidos multimedia sean muy atractivos y logren éxito, varias empresas desarrolladoras han generado una serie de dispositivos que permiten medir el nivel de atención y de agrado de sus contenidos en los usuarios. Algunas de las técnicas empleadas para el desarrollo de estos dispositivos se basan en el nivel de emociones [3], el grado de atención [4] y el registro de expresiones corporales [5, 6], entre otros [7].

Dentro de los dispositivos más utilizados actualmente se pueden encontrar: pulsímetros o electrocardiógrafos, para medir la frecuencia o ritmo cardiaco [8]; los GSR, que permiten medir la resistencia galvánica de la piel [9], la cual, según varios investigadores, cambia debido a la activación de las glándulas sudoríparas al generarse sentimientos de miedo, ira o sexuales; el electromiógrafo, que permite registrar la actividad eléctrica de músculos [10]; detectores o seguidores del movimiento de los ojos [11]; unidades inerciales para detectar movimientos bruscos de los usuarios; polisomnógrafos, para medir los cambios respiratorios, y uno de los más recientes, los electroencefalógrafos (ECG), que permiten el registro de la actividad bioeléctrica del cerebro [12]. Algunos de los dispositivos más conocidos comercialmente son: Mindwave, MindSet de NeuroSky [13], MindFlex de Mattel [14], Muse de InteraXon [15] y el EPOC de Emotiv.

En este trabajo se propone el uso de un dispositivo de captura de neuroseñales de bajo costo (dispositivo Emotiv-Epoc) para detectar y registrar las expresiones realizadas por los usuarios al ver el material multimedia. La idea, además de capturar los niveles de atención, frustración y excitación que proporciona este dispositivo, es registrar expresiones tales como la sonrisa, las carcajadas, el fruncimiento de cejas, ejercer presión con la mandíbula y el nivel de parpadeo, entre otros, con el fin de tener un conjunto más amplio de variables que puedan suministrar mayor información sobre la evaluación de los contenidos multimedia y así analizar cuáles fueron las pautas o segmentos de mayor y menor éxito para cambiar su esquema, generando un contenido altamente atractivo. Se decidió trabajar con este dispositivo de captura de neuroseñales debido a que es capaz de capturar 3 estados mentales [16], 13 Integración de un sistema de neuroseñales para detectar expresiones en el análisis de material multimedia pensamientos conscientes [17], expresiones faciales [18] y los movimientos de la cabeza, a través de dos giróscopos; además, cuenta con un kit de desarrollo de software, es liviano y tiene conectividad Bluetooth.

Este artículo se encuentra organizado de la siguiente forma: en la primera sección se hace una breve descripción de la captura de neuroseñales para la detección de las expresiones faciales de los usuarios del material multimedia; en la segunda se presenta el esquema de registro, y por último se presentan los resultados obtenidos y las conclusiones.

II. Sistema de captura de neuroseñales

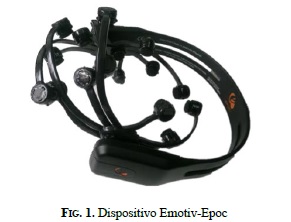

El dispositivo implementado para el desarrollo del sistema es el Emotiv-Epoc; dispositivo comercial de bajo costo (alrededor de 400 dólares) y fácil adquisición, factor clave para replicar el sistema.

El dispositivo Epoc captura y procesa señales eléctricas generadas por el cerebro, permitiendo estimar algunos datos del usuario, dentro de los cuales se pueden destacar tres categorías: referencias emotivas, expresivas y algunos datos cognitivos. El software versión desarrollador cuenta con tres suites, especializadas en la captura de datos de cada una de estas categorías. En la Fig. 1 se puede apreciar el dispositivo Emotiv-Epoc versión desarrollador e investigador, el cual cuenta con 16 sensores para la captura de neuroseñales.

Para procesar la información, el dispositivo se encarga de capturar las ondas cerebrales, clasificadas acorde con su frecuencia en: Delta (1-4 Hz), Theta (4-7 Hz),

Alfa (7-13 Hz) y Beta (13-30 Hz). La intensidad de estas ondas, junto con la localización de la parte del cerebro que las produce, permite estimar las emociones y expresiones del usuario en un momento determinado; este procedimiento es análogo al usado en la técnica de electromiografía. Cada vez que una persona va a realizar un movimiento, sus músculos generan pequeñas señales eléctricas que los controlan. En el caso del dispositivo de neuroseñales, cada vez que el usuario va a realizar un movimiento, el cerebro se activa en una región en específico, generando unas señales eléctricas que son transmitidas a través del sistema nervioso.

En la Fig. 2 se puede apreciar la actividad cerebral, según las ondas generadas, cuando un usuario realiza fuerza con la mandíbula (apretar los dientes); este gesto se puede identificar fácilmente por medio del análisis de las ondas beta, debido a que éstas se localizan en un sector determinado con una intensidad relativamente elevada. En la Fig. 3 se puede apreciar un avatar del usuario donde se ilustra que el sistema detectó el gesto correctamente.

Cada gesto producido por los usuarios tiene características particulares que permiten su identificación. La suite Emotiv-Expressive permite detectar los siguientes gestos:

- Levantar las cejas

- Fruncir la frente

- Sonreír

- Apretar los dientes

- Mueca con la boca hacia la izquierda o la derecha

- Carcajadas

Cada uno de los gestos reconocidos por el sistema puede representarse por medio de una señal con valores comprendidos entre cero y uno, indicando el nivel o probabilidad de reconociendo del gesto. Adicionalmente, cuando se reconocen los gestos, un avatar los reproduce, con el fin de imitarlos visualmente. En las Fig. 4 y 5 se muestran dos ejemplos del avatar, reconociendo los gestos de fruncir las cejas (o la frente) y realizar una mueca con la boca hacia la derecha, respectivamente.

Además del reconocimiento de gestos, el dispositivo Emotiv-Epoc tiene otra suite, denominada Emotiva, que permite reconocer emociones generadas por los usuarios a través del tiempo. Las emociones que puede reconocer esta suite son:

- Atención / Desinterés

- Frustración (corto y largo plazo)

- Meditación

- Excitación (corto y largo plazo)

III. Registro de expresiones para el análisis de material multimedia

A. Arquitectura del sistema

En la Fig. 6 se puede apreciar la arquitectura del sistema de neuroseñales para la detección de expresiones; en primer lugar se reproduce el material multimedia en un computador, tabla, televisor, teléfono inteligente, iPod, etc. El usuario hace uso del dispositivo de captura de neuroseñales mientras examina los contenidos; simultáneamente son registradas las señales emotivas y las expresiones que realiza.

Una vez termina la reproducción del material multimedia su diseñador selecciona las variables emotivas y expresivas que desea analizar. De acuerdo con los gestos realizados, el diseñador puede verificar si su contenido causó el impacto que esperaba o no. En caso de que no cumpla con los requerimientos se modifica el material de forma recurrente hasta obtener el deseado.

Algunos ejemplos de análisis de material multimedia pueden ser los siguientes:

- Las señales de atención/desinterés pueden reflejar si un usuario se aburre de un contenido, o medir el tiempo que estuvo atento.

- En películas de terror se espera que el usuario fluctúe sus niveles de excitación. A nivel de expresiones corporales, los usuarios suelen apretar los dientes y los niños suelen cerrar los ojos o moverlos repentinamente hacia los lados para evitar algunas escenas.

- En películas de acción es común que los usuarios aprieten los dientes en escenas donde los actores realizan fuerza o están en una situación de peligro.

- En la reproducción de contenido dramático es típico verificar los niveles emotivos de frustración.

- Para contenidos humorísticos se pueden verificar las expresiones de sonrisa o de carcajadas para medir el éxito de ellos.

B. Interfaz de análisis de las señales registradas

Con el fin de realizar un análisis numérico de las diferentes señales detectadas, se creó una interfaz que sincroniza la captura de las señales con la ejecución del material multimedia (en caso de usarse un computador); esta interfaz calcula de forma automática los intervalos de tiempo (rangos) en los cuales el usuario presentó niveles altos, medios y bajos para cada una de las señales; estos niveles se configuran de forma a priori. Para los experimentos presentados en este trabajo se toman las señales normalizadas (valores entre 0 y 1), los valores entre 0,85 y 1 se clasifican como altos, los valores entre 0,7 y 0,85 se consideran valores medios, y los que estén por debajo de 0,7 se asumen como bajos. Estos rangos de tiempo permiten subdividir temporalmente y clasificar el material multimedia.

El desarrollador del material multimedia puede analizar cada uno de los segmentos (rangos de tiempo) del material presentado de acuerdo con cada una de las señales registradas; adicionalmente, puede obtener medidas estadísticas como: la media, la mediana, la varianza y la desviación estándar.

En la Fig. 7 se ilustra un breve diagrama funcional de la interfaz de análisis desarrollada. Un ejemplo de los resultados obtenidos se presenta en la siguiente sección.

IV. Resultados

En uno de los experimentos realizados se tomó a un usuario con cabello corto, con el fin de asegurar un buen contacto entre los sensores con el cuero cabelludo y así obtener una mejor captura de las neuroseñales.

En la Fig. 8 se puede observar al usuario reproduciendo uno de los contenidos preestablecidos.

Se puede apreciar que la interfaz de neuroseñales es relativamente pequeña, lo cual, sumado a su bajo peso y a la conectividad inalámbrica (vía bluetooth), la hacen idónea para que los usuarios se olviden en unos pocos minutos de que la llevan puesta; esta es una característica de gran importancia, pues reduce las alteraciones en las emociones del usuario y evita lecturas erróneas debido a la ansiedad que produce el sentirse examinados. Por esta misma razón, antes de ejecutar los experimentos se reproducía un material multimedia sin el propósito de analizar, con el fin de adecuar un ambiente propicio al usuario, generarle confianza y llevarlo a un nivel emotivo estándar.

Durante los experimentos se pudo apreciar el correcto funcionamiento del sistema; incluso se identificó que es capaz de reconocer más de un gesto simultáneamente, tal como se aprecia en la Fig. 9 (sonreír y hacer un guiño). En la Fig. 10 se puede apreciar el registro de las expresiones corporales de un usuario a través de la suite expresiva. Cabe aclarar que el sistema cuenta con unos parámetros que permiten calibrar el nivel de sensibilidad con que se detecta cada de una las expresiones. Todas estas señales se pueden capturar por la interfaz desarrollada, con el fin realizar un análisis numérico de cada una de ellas.

En la Fig. 11 se aprecia el registro de las señales emotivas de un usuario durante un experimento realizado; se pueden identificar los niveles de atención, meditación y excitación. Este experimento consistió en reproducir una pauta publicitaria de una aerolínea (para no afectar el nombre de la compañía se evitará nombrarla), la cual involucra temas subrealistas, mujeres atractivas, contrastes de colores vivos con fondos oscuros y sofisticados instrumentos tecnológicos, entre otros. La duración de la pauta fue de aproximadamente 90 segundos. Se escogió esta pauta publicitaria en particular debido a que contaba con varias escenas y subtemas, además de caracterizarse por el empleo de varias técnicas de marketing.

Para realizar un análisis numérico de las señales obtenidas, la interfaz desarrollada permite, además de capturar los valores, calcular algunos datos estadísticos como: media, mediana, moda, desviación y variación estándar, análisis por histogramas, además de realizar una transformación para hacer un análisis en Fourier. En la Fig. 12 se aprecia un análisis general de la señal de atención, mostrando las zonas en las cuales se obtuvieron niveles altos, medios y bajos de atención; esto permite identificar las partes de la pauta que deben mejorar en caso de que se quiera aumentar el impacto esperado en los usuarios.

Adicionalmente, si el productor quisiese obtener información avanzada acerca de las señales emotivas, el sistema puede generar datos como la transformada rápida de Fourier, para realizar un análisis frecuencial. En la Fig. 13 se pueden apreciar los resultados de esta transformada para la señal de atención.

Uno de los principales datos que genera la interfaz y que proporciona gran ayuda a los productores del material es el cálculo del porcentaje de tiempo en el cual los usuarios prestaron atención. En la Fig. 14 se ilustran los resultados para la señal de atención, los cuales evidenciaron que el usuario estuvo muy atento durante 9,01% del tiempo de la pauta publicitaria; tuvo un nivel medio de atención durante el 56,09% del tiempo, y un nivel bajo durante el restante 34,88%.

En la Tabla 1 se ilustran algunos datos estadísticos que describen el comportamiento de la señal de atención durante el desarrollo del experimento. Un parámetro interesante puede ser el máximo valor con el cual el desarrollador del material multimedia puede evidenciar cuál fue el evento de mayor relevancia de la pauta publicitaria. Para el experimento ejecutado se reconoció que el evento que causó mayor atención en el usuario fue la aparición de un dispositivo que permitie observar aparentemente debajo de la ropa de las personas (un escáner de un aeropuerto).

Para que el desarrollador del material multimedia pueda realizar un análisis más exhaustivo, la interfaz divide el tiempo de ejecución en varios rangos, permitiendo conocer el tiempo inicial y final y el valor medio de cada segmento. En la Tabla 2 se aprecian los resultados del experimento. Al contrastar el rango de mayor nivel de atención con el cuestionario escrito por el usuario (encuesta) se pudo evidenciar que coinciden claramente. Una característica que despierta bastante interés es que al comparar los rangos de tiempo obtenidos en el análisis con la pauta publicitaria, se puede observar una clara similitud con los temas tratados. Los temas que causaron menor interés en el usuario examinado fueron: dos escenas de personal de asistencia del avión sirviendo comidas y una escena en la que unas personas aparecen volando como pájaros.

Este tipo de análisis se ejecuta para cada una de las señales emotivas descritas anteriormente. De las otras neuroseñales se puede recalcar que el usuario aumentó significativamente su nivel de excitación con la presentación de la pauta publicitaria, evidenciándose dos picos sobresalientes; el primero corresponde a la aparición de una escena que mostraba unos labios rojos y grandes (también mencionada por el usuario en el cuestionario), y el segundo, a la escena en la que aparece toda la tripulación montada en un ala del avión.

En cuanto a las expresiones faciales, se evidenció que los usuarios tendían a sonreír en la escena del escáner del aeropuerto debido a que uno de los viajeros realizaba un movimiento picaresco. Este evento se pudo evidenciar visualmente en la toma de los datos, al igual que en la neuroseñal que representa esta expresión.

V. Conclusiones

El uso de dispositivos de captura de neuroseñales es una técnica que permite registrar de forma efectiva las expresiones faciales que realizan los usuarios al observar material multimedia, con las cuales se pueden evidenciar el comportamiento y la interacción de ellos.

Gracias al sistema implementado, los desarrolladores de material multimedia contarán con una herramienta más que les permitirá llegar a sus usuarios de forma efectiva y complaciente, brindándoles una mejor experiencia, sin recurrir a grandes costos y reduciendo los tiempos de producción.

Este proyecto ha evidenciado ser un gran instrumento para las diversas áreas en donde se requiere conocer más allá de lo que puede mencionar el usuario; es decir, el empresario que quiera conocer lo que realmente sucede en la mente del consumidor y que desee mayor acierto con su publicidad podrá utilizar este dispositivo, pues en él se pueden observar directamente algunas emociones sin que sean manipuladas por el que está realizando la prueba, lo que permite que sea un método efectivo y confiable.

La interfaz desarrollada permite obtener medidas cuantitativas del impacto del material presentado sobre el usuario. Las señales emotivas que permitieron obtener mayor información para su análisis fueron, en su orden, la atención y la excitación.

La división temporal del material multimedia presentado por rangos de acuerdo con los niveles de atención, al igual que los parámetros estadísticos, permite a los desarrolladores realizar un análisis más profundo de cada una de las escenas, y clasificarlas.

Referencias

[1] L. M. Keefe, "What Is the Meaning of Marketing?" Marketing News, pp. 17-18. Sep. 15, 2004.

[2] G. Du-Jian, L. Wang, Q. Zheng, Y. Liu-Li, "Neuromarketing: Marketing through Science", International Joint Conference on Service Sciences (IJCSS), pp.285-289. Mayo, 2012.

[3] M. Soleymani, G. Chanel, J. J. Kierkels, T. Pun, "Affective Characterization of Movie Scenes Based on Multimedia Content Analysis and User's Physiological Emotional Responses", ISM 2008. Tenth IEEE International Symposium on Multimedia, pp.228-235, 15-17 December, 2008.

[4] K. Yaomanee, S. Pan-ngum, P. I. N. Ayuthaya, "Brain signal detection methodology for attention training using minimal EEG channels", 10th International Conference on ICT and Knowledge Engineering (ICT & Knowledge Engineering), pp. 84-89, Nov. 2123,2012.

[5] H. Kiwan, K. Jeonghun, L. Hyeongrae, P. Jinsick, C. Sangwoo, K. Jae-Jin, K. In Young; S. I. Kim, "Measurement of Expression Characteristics in Emotional Situations using Virtual Reality", IEEE Conference on Virtual Reality (VR 2009), pp. 265, 266, March14-18, 2009.

[6] I. A. Oz, M. M. Khan, "Efficacy of biophysiological measurements at FTFPs for facial expression classification: A validation", IEEE-EMBS International Conference on Biomedical and Health Informatics (BHI), pp.108-111, January 5-7, 2012.

[7] Z. Ren, X. Qi, G. Zhou, H. Wang, "Exploiting the Data Sensitivity of Neurometric Fidelity for Optimizing EEG Sensing", Internet of Things Journal, IEEE , no. 99, pp. 1-11, 2014.

[8] Y. Chih-Chin, J. T. Huang, "The era of Cloud Computer thru bio-detecting and openresources to achieve the Ubiquitous devices", IEEE International Conference on Consumer Electronics (ICCE), pp.580-583. January, 2012.

[9] L. Grimaldi, "Measuring the Efficacy of Advertising Communication with Neuroscience Methods: An Experiment Performed by Telecom Italia", Pulse, IEEE, vol. 3, no. 3, pp. 48-52. May 2012.

[10] C. Chuan-Yu, L. Yu-Mon, Z. Jun-Ying, "Physiological Angry Emotion Detection Using Support Vector Regression", 15th International Conference on Network-Based Information Systems (NBiS), pp.592-596. Sep. 2012.

[11] H. Touyama, "Post-saccadic event related potential toward a new technique for information retrieval", IEEE International Conference on Systems, Man, and Cybernetics (SMC), pp. 2939-2942. Oct. 2012.

[12] R. Ohme, M. Matukin, "A Small Frog That Makes a Big Difference: Brain Wave Testing of TV Advertisements", Pulse, IEEE, vol. 3, no. 3, pp. 28-33. Mayo, 2012.

[13] M. Eid, A. Fernández, "Read Go Go!: Towards real-time notification on readers' state of attention", XXIV International Symposium on Information, Communication and Automation Technologies (ICAT), pp.1-6. Nov. 2013.

[14] J. Katona, I. Farkas, T. Ujbanyi, P. Dukan, A. Kovari, A., "Evaluation of the NeuroSky MindFlex EEG headset brain waves data", IEEE 12th International Symposium on Applied Machine Intelligence and Informatics (SAMI), pp. 91-94, January 23-25, 2014.

[15] W. A. Dijk, W. van der Velde, W. J. M. Kolkman, H. J. G. M. Crijns, K. I. Lie, "Integration of the Marquette ECG management system into the Department Information System using the Integración de un sistema de neuroseñales para detectar expresiones en el análisis de material multimedia European SCP-ECG Standard", Computers in Cardiology, pp.397-400, Sep.10-13,1995.

[16] H. Boutani, M. Ohsuga, "Applicability of the 'Emotiv EEG Neuroheadset' as a user-friendly input interface", 35th Annual International Conference of the IEEE Engineering in Medicine and Biology Society (EMBC), pp.1346-1349, Jul.3-7, 2013.

[17] K. Holewa, A. Nawrocka, "Emotiv EPOC neuroheadset in brain- computer interface", 15th International Carpathian Control Conference (ICCC), pp.149-152, May28-30, 2014.

[18] K. George, A. Iniguez, H. Donze, "Automated sensing, interpretation and conversion of facial and mental expressions into text acronyms using brain-computer interface technology", Proceedings of 2014 IEEE International Conference on Instrumentation and Measurement Technology (I2MTC), pp.12471250, May 12-15, 2014.